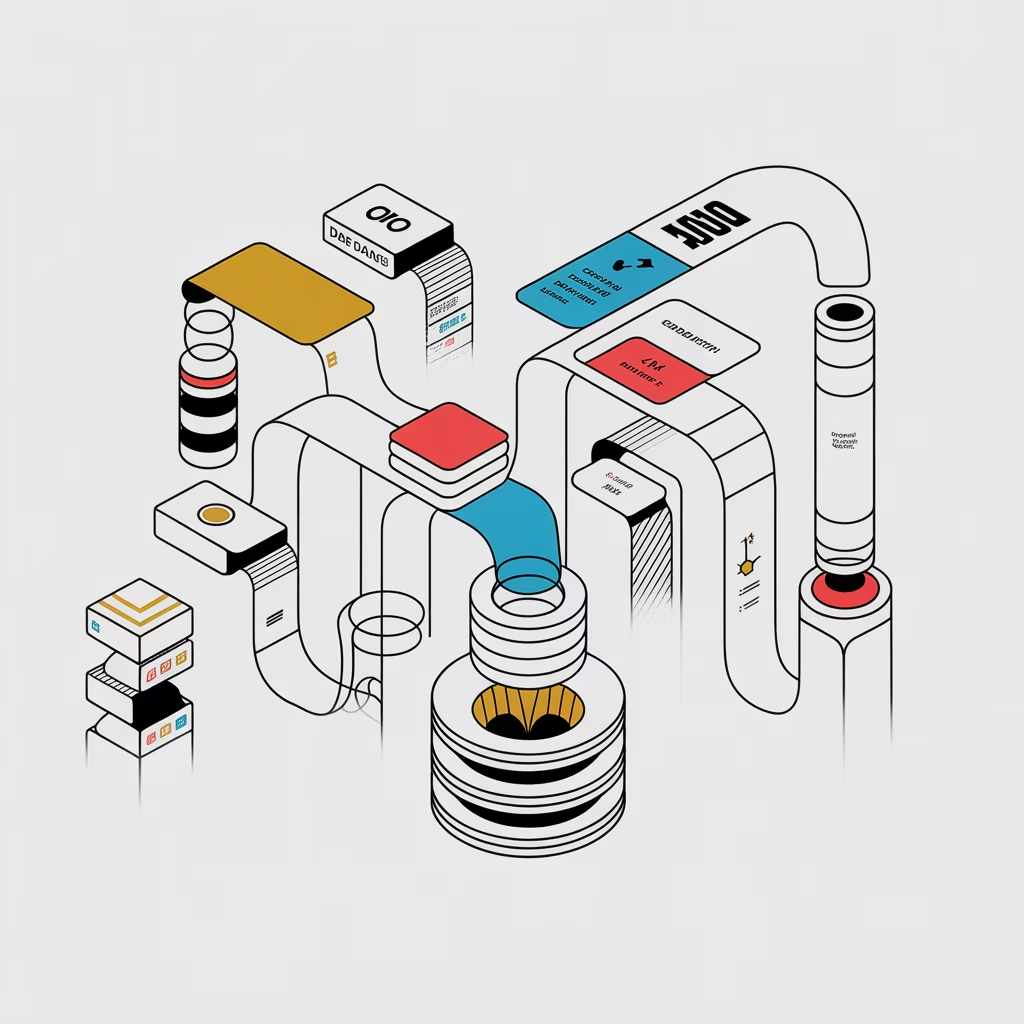

Een data pipeline is een geautomatiseerde reeks stappen waarmee ruwe data systematisch wordt verzameld, getransformeerd en beschikbaar gemaakt voor analyse of modeltraining.

In moderne AI- en data-architecturen fungeren pipelines als de “bloedvaten” van het datasysteem: ze zorgen dat gegevens efficiënt en betrouwbaar van bron naar eindtoepassing stromen.

Van sensoren tot dashboards, en van ruwe databron tot getraind model — een goed ontworpen pipeline bepaalt de snelheid, kwaliteit en schaalbaarheid van elke datagedreven organisatie.

Werking

Een typische data pipeline bestaat uit meerdere opeenvolgende fasen:

- Data-acquisitie (Extract): verzamelen van data uit diverse bronnen zoals databases, API’s, IoT-sensoren, logbestanden of externe platforms.

- Data-transformatie (Transform): opschonen, verrijken, normaliseren en structureren van data zodat deze geschikt is voor analyse of modeltraining.

- Data-opslag (Load): laden van de bewerkte data in een data warehouse, data lake of feature store.

- Data-validatie en monitoring: controleren op consistentie, volledigheid en anomalieën tijdens de verwerking.

- Distributie en consumptie: aanbieden van data aan analytische tools, dashboards of machine learning-modellen.

In machine learning-context worden pipelines vaak uitgebreid met extra stappen:

- Feature engineering: genereren van kenmerken die relevant zijn voor het model.

- Model training & deployment: automatisch trainen, testen en uitrollen van AI-modellen.

- Feedback loops: integreren van modelresultaten en gebruikersfeedback voor continue verbetering.

Veel gebruikte technologieën zijn Apache Airflow, Dagster, Prefect, Kedro, en cloud-native oplossingen zoals AWS Glue, Azure Data Factory en Google Cloud Dataflow.

Kenmerken

- Automatisering: minimaliseert handmatige stappen en verhoogt reproduceerbaarheid.

- Schaalbaarheid: geschikt voor zowel batch- als streamingdata.

- Modulariteit: elke stap (extract, transform, load) is afzonderlijk beheersbaar.

- Betrouwbaarheid: ingebouwde foutdetectie en herstelfuncties.

- Transparantie: logging, monitoring en data lineage maken processen traceerbaar.

- Integratie: koppelt meerdere bronnen en systemen binnen één datastroom.

Toepassingen

Data pipelines worden in vrijwel elk datagedreven domein ingezet:

- Business analytics: geautomatiseerde datastromen voor dashboards en rapportages.

- Machine learning & AI: leveren van trainingsdata en continue modelupdates.

- IoT en sensornetwerken: realtime verwerking van datastromen.

- Financiële dienstverlening: fraudedetectie en risicomodellen.

- Gezondheidszorg: verwerking van patiënt- en sensorgegevens.

- E-commerce: personalisatie en aanbevelingssystemen.

Uitdagingen

- Data quality: inconsistente of onvolledige data kan hele processen verstoren.

- Complexiteit: onderhoud van meerdere afhankelijkheden en schema’s.

- Latency: balans vinden tussen real-time verwerking en resourcegebruik.

- Beveiliging: bescherming van gevoelige data tijdens overdracht en opslag.

- Versiebeheer: controle over data-, code- en schemawijzigingen.

- Operationele betrouwbaarheid: detecteren van fouten en automatisch herstel.

Samenvatting

Data pipelines vormen de ruggengraat van elke datagedreven organisatie. Ze zorgen voor een betrouwbare en herhaalbare stroom van data — van ruwe bron tot model en rapportage.

Een goed ontworpen pipeline waarborgt dat AI-modellen beschikken over actuele, consistente en gevalideerde data. Door automatisering, monitoring en kwaliteitscontrole te combineren, maken pipelines schaalbare en duurzame data-infrastructuur mogelijk.

Bron: Blackbirds.ai — AI & Data Consultancy