Edge AI verwijst naar het uitvoeren van kunstmatige intelligentie-algoritmen direct op lokale apparaten — zoals smartphones, sensoren of industriële machines — in plaats van in de cloud.

On-device inference is het proces waarbij een getraind AI-model voorspellingen doet op dat lokale apparaat.

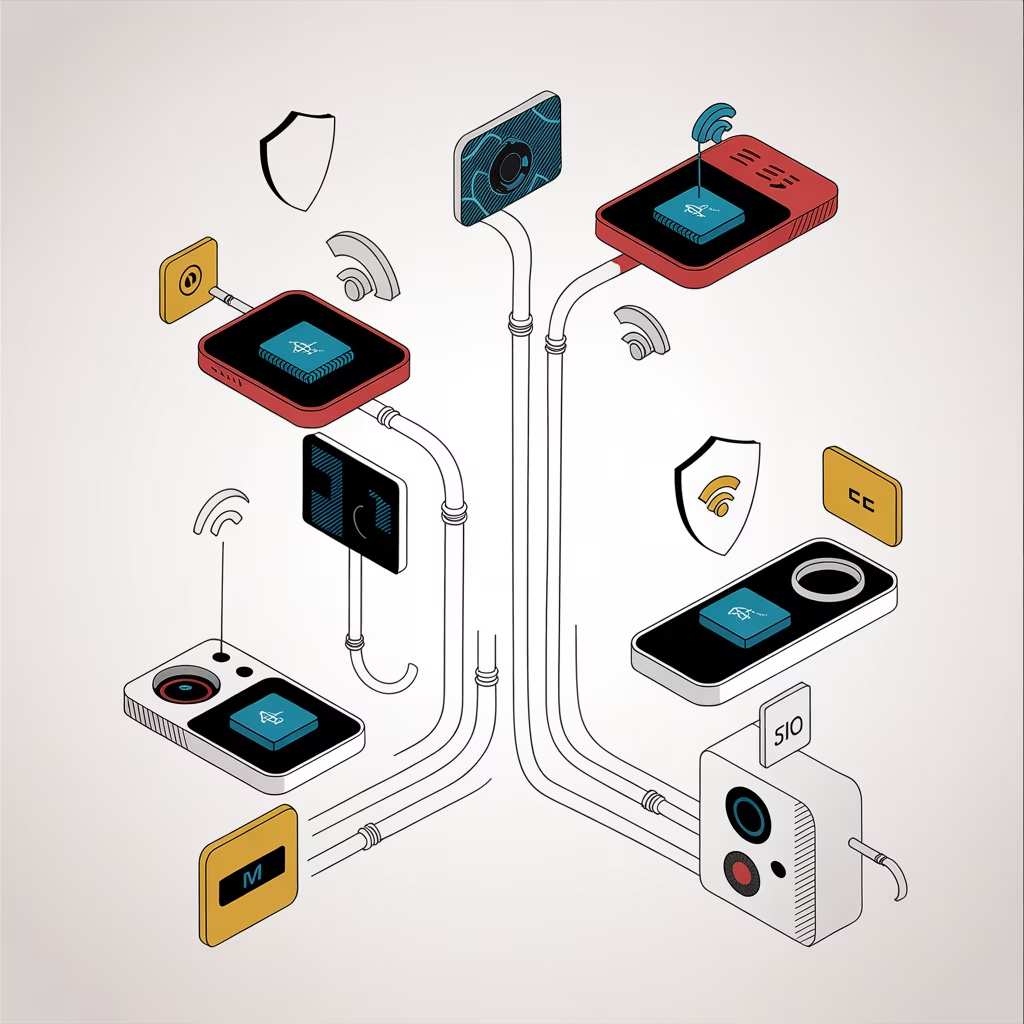

Door rekenkracht “naar de rand” van het netwerk te verplaatsen, worden snelheid, privacy en autonomie aanzienlijk verbeterd. Edge AI vormt daarmee een essentieel onderdeel van moderne, gedistribueerde AI-architecturen.

Werking

Traditioneel worden AI-modellen getraind en uitgevoerd in datacenters of cloudomgevingen, waar voldoende rekenkracht beschikbaar is.

Bij Edge AI verloopt dit anders:

- Modeltraining: vindt meestal plaats in de cloud of op krachtige servers met grote datasets.

- Modeloptimalisatie: het getrainde model wordt verkleind en geoptimaliseerd voor beperkte hardware via technieken zoals quantization, pruning en knowledge distillation.

- On-device inference: het geoptimaliseerde model draait lokaal op edge-apparatuur, waardoor beslissingen direct kunnen worden genomen zonder dataverkeer naar de cloud.

- Feedback en updates: resultaten of samenvattingen kunnen periodiek worden teruggestuurd voor hertraining of modelupdates.

Edge AI maakt gebruik van gespecialiseerde hardware zoals NVIDIA Jetson, Google Coral, Apple Neural Engine (ANE) of Qualcomm AI Engine, die berekeningen versnellen met lage energieconsumptie.

Kenmerken

- Lage latentie: beslissingen worden in milliseconden genomen zonder afhankelijkheid van netwerkverbinding.

- Privacybescherming: gevoelige data blijven lokaal op het apparaat.

- Betrouwbaarheid: systemen blijven functioneren, zelfs zonder internetverbinding.

- Efficiëntie: minder dataverkeer en lagere cloudkosten.

- Modeloptimalisatie: vereist compacte, energiezuinige modellen.

- Decentrale architectuur: past in IoT- en edge computing-ecosystemen.

Toepassingen

Edge AI en on-device inference worden breed toegepast in scenario’s waar realtime respons of dataprivacy cruciaal is:

- Autonome voertuigen: beeldherkenning en besluitvorming zonder cloudvertraging.

- Slimme camera’s: detectie van objecten of personen direct in het apparaat.

- Gezondheidszorg: monitoring van vitale functies met wearables.

- Industrie 4.0: kwaliteitscontrole en voorspellend onderhoud in fabrieken.

- Retail: klantgedraganalyse op locatie zonder data-opslag in de cloud.

- Smartphones: spraakherkenning, gezichtsontgrendeling en vertaling on-device.

Uitdagingen

- Beperkte rekenkracht: edge-apparaten hebben minder geheugen en processorkracht dan servers.

- Modeloptimalisatie: verkleinen van modellen zonder nauwkeurigheidsverlies is complex.

- Energieverbruik: AI-inferentie kan de batterijduur beïnvloeden.

- Beheer en updates: synchronisatie van duizenden edge-modellen vereist sterke MLOps-processen.

- Beveiliging: lokale uitvoering brengt risico’s op device-manipulatie of datadiefstal.

- Standaardisatie: gebrek aan uniforme frameworks en protocollen voor edge AI.

Samenvatting

Edge AI en on-device inference brengen kunstmatige intelligentie dichter bij de bron van data. Door modellen lokaal te draaien, worden vertraging, privacyrisico’s en afhankelijkheid van cloudinfrastructuur verminderd.

Deze technologie maakt realtime, veilige en efficiënte AI-toepassingen mogelijk — van autonome voertuigen tot draagbare sensoren — en is een belangrijke bouwsteen van de toekomst van gedistribueerde intelligentie.

Bron: Blackbirds.ai — AI & Data Consultancy